微信扫码咨询

C114讯 10月11日消息(岳明)大模型需要大算力,大算力需要大集群,大集群需要大网络!

如何去构建这张大网络,在本周举行的“Advancing AI 2024”上,AMD给出了明确的答案:全面拥抱以太网,全面拥抱DPU。

UEC加速成熟:Ethernet is the answer

与传统数据中心存在很大不同,主要由GPU服务器联网构成的智算中心需要完全不同的网络架构。

当大模型训练时,并行计算节点越多,通信效率越重要,智算网络性能成为集群算力提升的关键。但传统网络技术难以适应大规模AI集群的发展需求,在实际组网过程中面临着四大难题:大规模网络拥塞控制难、突发大象流负载均衡难、巨量链路长期稳定运行难、敏感隐私数据安全保障难。

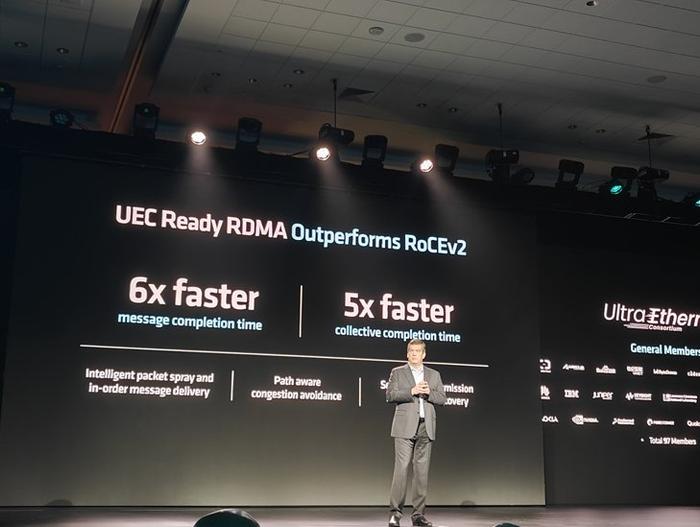

对此,业界有几种不同的解决方案。比如英伟达主导的InfiniBand,虽然现在市占率很高,但InfiniBand在产业开放性、部署成本方面非常不友好。另外就是从底层革新传统以太网机制,在最大限度的利用以太网产业开放性和成熟性的同时,重构高扩展、高稳定、高可靠的以太网堆栈,满足大规模AI和HPC不断增长的网络需求。UEC就是该技术路径的典型代表,通过构建支持RoCE(RDMA over Converged Ethernet)的无损网络,做到不丢包,支持以太网RDMA,满足高带宽和高利用率需求。

在“Advancing AI 2024”上,AMD执行副总裁,数据中心解决方案事业部总经理Forrest Norrod就指出,网络成为制约AI系统性能的关键,平均30%的训练时间被用来等待联网;而在训练和分布式推理中,通信更是占40%-75%的时间。这对于动辄部署万卡集群的用户而言是难以承受的。

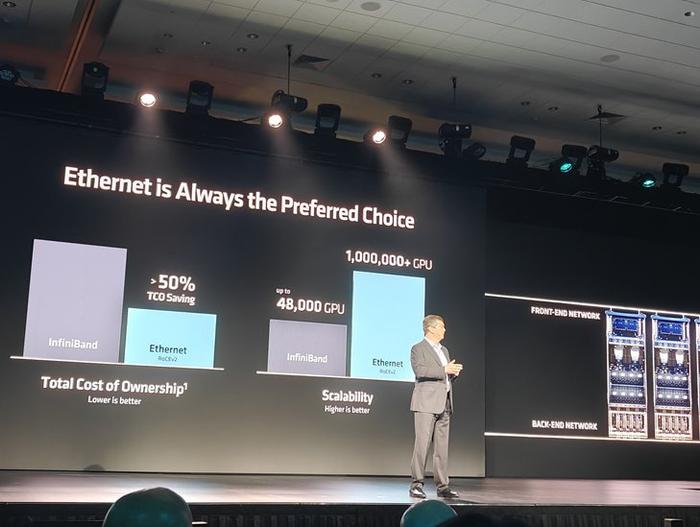

在他看来,UEC是AI网络变革的首选:从总体拥有成本(TCO)角度来看,相比较于InfiniBand,以太网下降了50%;可扩展性角度来看,以太网可以支持高达100万+GPU的超大规模集群部署,远远超过InfiniBand;从生态系统的角度来看,UEC联盟已经有超过97名成员,其中包括微软、Meta、AMD、博通等众多大厂,UEC1.0规范也将在明年一季度发布。有意思的是,英伟达在前段时间也加入了UEC。

在“Advancing AI 2024”的现场,不仅是AMD,思科、微软等多位技术负责人均进行了分享。他们认为在当前的RDMA 环境下,超以太网协议有望支持百万节点互联,同时以太网的开放特性,能够让诸如LPO等新技术加速渗透,带来高性价比、高容量、高开放程度的AI网络。

第三代DPU Salina:以AI速度交付网络创新

在AMD的AI网络战略拼图中,既有关注底层芯片级互联的Infinity Fabric,极具性能优势的在AMD的AI网络战略拼图中,既有关注底层芯片级互联的Infinity Fabric,但DPU占据了更为重要的版图。

对于云服务提供商而言,要实现利益最大化,就必须要充分释放CPU/GPU等算力资源。云服务先驱亚马逊率先引入了DPU概念和产品,实现将网络、存储、管理、安全和监控等工作负载一并卸载,而这也为亚马逊赢得了市场先机。

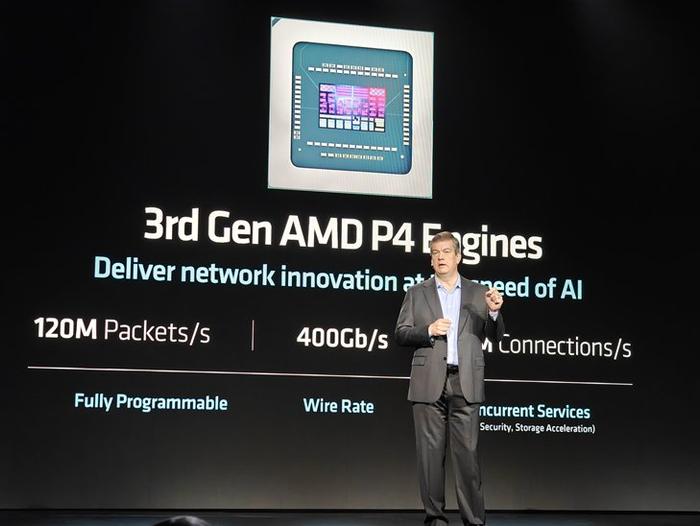

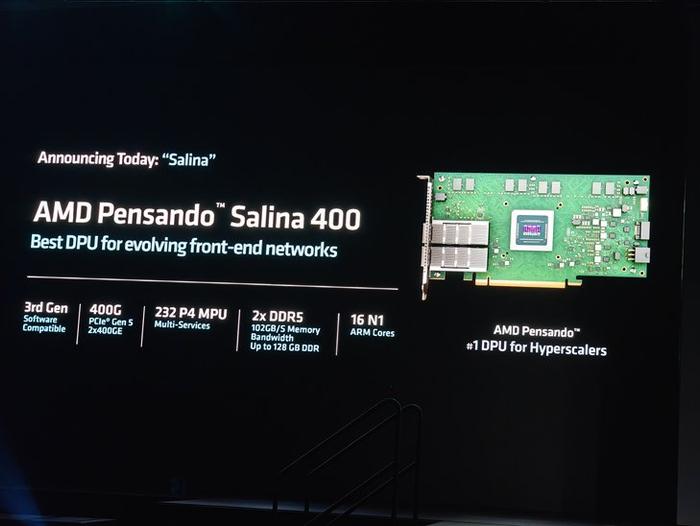

DPU的好处得到用户的广泛认可。2022年4月,AMD斥资19亿美元购买DPU厂商Pensando,并成功实现了第一代Capri和第二代Elba两大DPU的量产。在“Advancing AI 2024”的现场,AMD正式发布了采用P4引擎的第三代DPU产品—Salina,以AI速度交付网络创新。

从AMD提供的产品技术规格上来看,Salina采用5nm制程工艺打造,实现两倍于上一代的性能。而且,AMD Pensando DPU支持软件前向兼容,节省了应用程序开发所需的时间。在性能方面,Salina最高支持800G(400G*2)网络,这与AI数据中心网络演进是完全匹配的,同时Salina支持完全可编程,具备相当的灵活性。

在会议现场,包括IBM云、微软Azure、甲骨文云、思科等用户的技术高管也都谈到了AMD Pensando DPU在不同应用场景中的价值。微软Azure主要是用基于DPU的智能交换机来完成SDN解耦,而甲骨文云和IBM云则是硬件上用到DPU卡,软件上除了使用Pensando提供的SDK和库,还有定制的逻辑应用,方便客户添加软件定义的服务。

13560189272

13560189272  地址:广州市天河区黄埔大道西201号金泽大厦808室

地址:广州市天河区黄埔大道西201号金泽大厦808室